Ming-flash-omni-Preview - 蚂蚁集团开源的全模态大模型

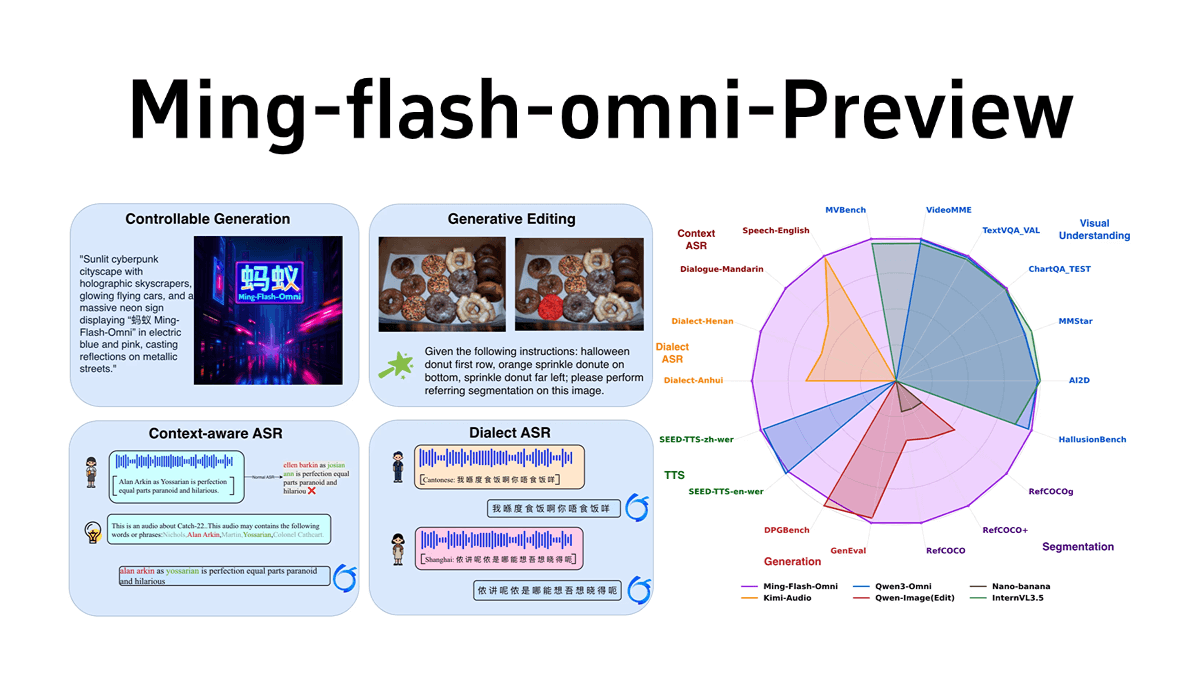

Ming-flash-omni-Preview是蚂蚁集团inclusionAI发布的开源全模态大模型,参数规模达千亿,基于Ling 2.0的稀疏MoE架构,总参数103B,激活9B。在全模态理解和生成能力上表现出色,尤其在可控图像生成、流式视频理解、语音及方言识别、音色克隆等方面有显著优势。首创“生成式分割范式”,实现细粒度空间语义控制,图像生成可控性强;能对流式视频进行细粒度理解,实时提供说明;在语音领域,支持上下文感知语音理解及方言识别,对15种中国方言理解能力大幅提升,音色克隆能力也显著增强。模型的训练架构高效,通过多项优化提升了训练吞吐量。

Ming-flash-omni-Preview的功能特色

全模态能力:支持多种模态输入输出,包括图像、文本、视频和音频,具备强大的多模态理解和生成能力。

可控图像生成:首创“生成式分割范式”,实现细粒度空间语义控制,图像生成和编辑的可控性显著提升。

流式视频理解:能对流式视频进行细粒度理解,实时提供相关物体和交互的说明,支持基于现实场景的持续对话。

语音及方言理解:支持上下文感知语音理解(ContextASR)和方言识别,对15种中国方言的理解能力大幅增强。

音色克隆:语音生成能力升级,能够有效克隆原本对话的音色到新产生的对话中,中英文混合发音稳定。

高效训练架构:基于稀疏MoE架构,通过多项优化提升训练吞吐量,实现各模态的“大容量、小激活”。

开源与社区支持:模型和代码已开源,可在GitHub、HuggingFace和ModelScope找到相关资源,方便开发者试用和反馈。

Ming-flash-omni-Preview的核心优势

千亿参数规模:作为首个参数规模达到千亿的开源全模态大模型,拥有强大的计算能力和丰富的语义理解能力。

稀疏MoE架构:基于Ling 2.0的稀疏MoE架构,实现“大容量、小激活”,在保持高效计算的同时,提升了模型的性能和灵活性。

多模态领先性能:在图像生成、视频理解、语音识别等多个模态任务上达到开源全模态模型的领先水平,尤其在可控图像生成和方言识别方面表现出色。

创新的生成式分割范式:提出“生成式分割即编辑”的协同训练范式,将图像分割重构为语义保持的编辑任务,显著提升了图像生成的可控性和编辑质量。

高效训练与优化:通过序列打包和弹性编码器分片等技术,解决了多模态训练中的数据异构性和模型异构性问题,大幅提升训练吞吐量。

Ming-flash-omni-Preview官网是什么

GitHub仓库: https://github.com/inclusionAI/Ming

HuggingFace模型库: https://huggingface.co/inclusionAI/Ming-flash-omni-Preview

Ming-flash-omni-Preview的适用人群

人工智能研究人员:致力于多模态研究,可利用模型探索图像、视频、语音等多模态融合的新方法和应用场景。

开发工程师:希望在项目中集成多模态功能,如开发智能视频分析、语音交互、图像生成等应用,可借助其强大的多模态能力快速实现。

数据科学家:需要处理和分析多模态数据,可用于数据预处理、特征提取等,提升数据处理效率和质量。

产品设计师:关注用户体验和产品创新,可利用其多模态生成能力设计更具创意和交互性的产品功能。

教育工作者:可将其应用于教育领域,如开发智能教育软件,通过语音识别、图像生成等功能提升教学效果和互动性。

内容创作者:如视频制作者、设计师、作家等,可利用其生成能力快速生成创意内容,提高创作效率。